솔직히 말해봅시다. 지금 이 글을 읽는 여러분의 회사에도 '인간 API' 역할을 하는 엔지니어가 한 명쯤은 있을 겁니다. 훌륭한 석박사 연구원들이 포진해 있지만, 정작 그들은 리눅스 터미널 앞에서 쩔쩔매고, 결국 누군가에게 슬랙으로 메시지를 보냅니다. "김 연구원님, 저번에 돌려주신 그 모델, 파라미터만 바꿔서 다시 돌려주실 수 있나요?" 그 순간, 연봉 1억이 넘는 머신러닝 엔지니어는 고작 파이썬 스크립트를 대신 실행해 주는 오퍼레이터로 전락합니다. 제가 현업에서 가장 혐오하는 '비효율의 극치'가 바로 이 지점입니다.

최근 YC(Y Combinator)에 등장한 'Tamarind Bio'라는 팀의 창업 스토리를 보며 쓴웃음을 지을 수밖에 없었습니다. 창업자 Deniz는 스탠포드 연구실에서 일할 때, 박사후연구원들의 부탁을 받아 수만 개의 입력을 처리하는 모델을 대신 돌려주는 일을 했다고 합니다. 연구실의 모든 계산생물학 작업이 학부생 한 명의 '수작업'에 의존하고 있었던 셈입니다. 이 비극은 학교를 벗어나 대형 제약사(Big Pharma)로 가도 똑같이 반복됩니다. 데이터 사이언스 팀장의 업무 절반이 타 부서의 요청으로 스크립트를 실행하는 일이라니, 이게 말이 됩니까? 회사의 목표는 암을 치료하는 신약을 만드는 것이지, 도커(Docker) 컨테이너 관리 기술을 자랑하는 게 아니지 않습니까.

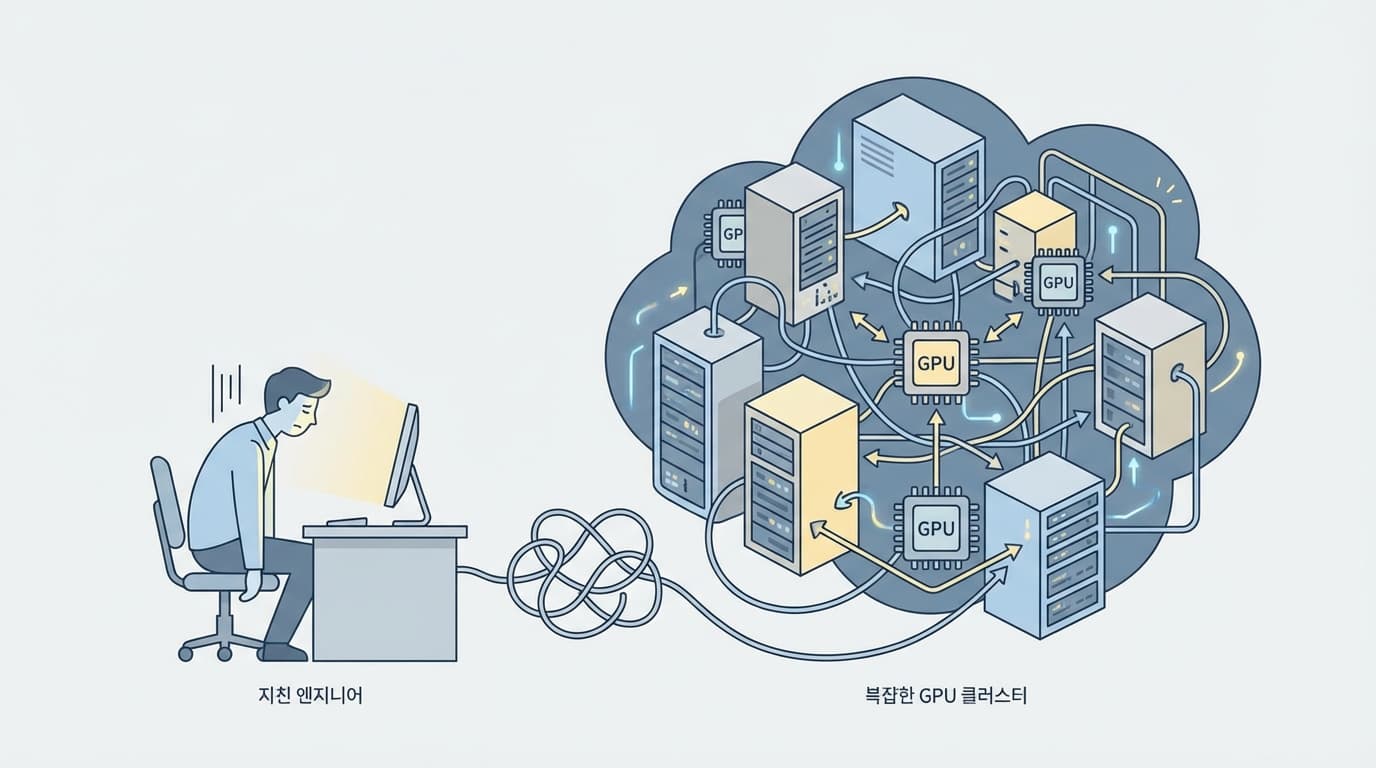

많은 엔지니어들이 '자체 구축(In-house)'의 환상에 빠져 있습니다. AlphaFold 같은 거대 모델을 직접 서빙하겠다고 GPU 서버를 사들이고, 쿠버네티스 클러스터를 구축합니다. 하지만 현실은 냉혹합니다. 바이오 분야의 추론(Inference)은 일반적인 LLM 채팅 서비스와 다릅니다. 추론 한 번에 수 시간이 걸리기도 하고, 메모리 요구량은 살인적입니다. 게다가 연구원들이 가져오는 데이터 포맷은 제각각입니다. 이걸 표준화(Standardization)하고, 비동기 큐(Queue)를 관리하고, GPU 유휴 자원을 최소화하는 스케줄러까지 만들다 보면, 정작 중요한 '신약 개발'은 뒷전이 됩니다. 우리는 이걸 'GPU 난로 만들기'라고 부릅니다. 돈만 태우고 비즈니스 가치는 없는 행위죠.

Tamarind Bio가 영리한 점은 바로 이 '지옥'을 파고들었다는 것입니다. 그들은 단순히 오픈소스 모델을 호스팅하는 것을 넘어, 데이터 스키마를 표준화했습니다. 입력값이 엑셀이든, CSV든, 혹은 텍스트 파일이든 상관없이 모델이 이해할 수 있는 형태로 변환해 주는 전처리 파이프라인을 구축한 겁니다. 그리고 개발자를 위한 API뿐만 아니라, 터미널 공포증이 있는 과학자들을 위한 웹 UI를 제공했습니다. 결과적으로 연구원들은 동물 피를 뽑는 실험 대신 클릭 몇 번으로 단백질 구조를 예측하게 되었고, 엔지니어는 인프라 관리의 늪에서 해방되었습니다.

엔지니어링의 본질은 결국 '트레이드오프(Trade-off)'를 결정하는 것입니다. 우리 회사의 핵심 역량이 인프라 구축에 있는지, 아니면 그 인프라 위에서 돌아가는 서비스에 있는지 냉정하게 판단해야 합니다. 만약 여러분이 바이오 스타트업이나 AI 솔루션 기업에 있다면, 제발 부탁하건대 바퀴를 다시 발명하지 마십시오. 이미 잘 만들어진 추론 플랫폼을 쓰는 것은 부끄러운 일이 아닙니다. 오히려 한정된 리소스로 비즈니스 임팩트를 내야 하는 상황에서 인프라 바닥부터 파고 있는 것이야말로 직무 유기입니다.

주니어 개발자들이여, 화려한 모델 파이닝 튜닝이나 아키텍처 설계에만 목매지 마십시오. 진짜 실력은 내 동료들이 반복적인 삽질을 하지 않도록 시스템을 만드는 데서 나옵니다. 내가 짠 코드가 누군가의 퇴근 시간을 1시간 앞당겨 줄 때, 혹은 수동으로 하던 일을 자동화하여 비용을 1/10로 줄였을 때, 비로소 우리는 '엔지니어'라는 타이틀을 달 자격이 생깁니다. 그게 아니라면 우리는 그저 비싼 GPU를 덥히는 난로 관리자에 불과할 테니까요.

![[브루킹스 연구소] 50개국 현장 조사: AI가 인간의 뇌를 '퇴화'시킨다는 결정적 증거](/_next/image?url=https%3A%2F%2Fstorage.googleapis.com%2Fpoooling-blog%2Fblog-images%2F2026%2F02%2F02%2F2620_b8418316.png&w=3840&q=75)